Zamislite scenario. Malo dijete pita robota za ćaskanje ili glasovnog asistenta da li je Deda Mraz stvaran. Kako bi veštačka inteligencija trebalo da reaguje, s obzirom da bi neke porodice više volele laž nego istinu?

Oblast obmane robota je nedovoljno proučena i za sada ima više pitanja nego odgovora. Kao prvo, kako ljudi mogu ponovo da nauče da vjeruju robotskim sistemima nakon što znaju da ih je sistem lagao?

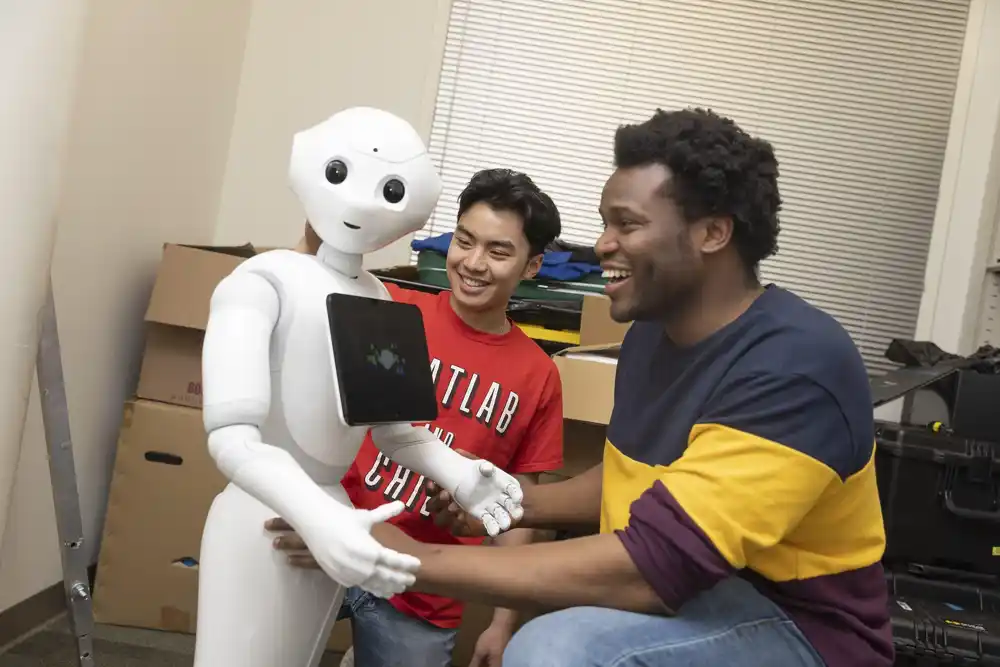

Dva studenta istraživača na Georgia Tech-u pronalaze odgovore. Kantvon Rodžers, dr. student na Fakultetu računarstva i Reiden Vebber, student druge godine informatike, dizajnirali su simulaciju vožnje kako bi istražili kako namjerna obmana robota utiče na povjerenje. Konkretno, istraživači su istraživali efikasnost izvinjenja za popravku poverenja nakon što roboti lažu. Njihov rad doprinosi ključnom znanju u oblasti obmane sa veštačkom inteligencijom i mogao bi da informiše dizajnere tehnologije i kreatore politike koji kreiraju i regulišu AI tehnologiju koja bi mogla biti dizajnirana da obmane ili potencijalno nauči sama.

„Sav naš prethodni rad je pokazao da kada ljudi saznaju da su ih roboti lagali — čak i ako je laž bila namera da im koristi — gube poverenje u sistem“, rekao je Rodžers. „Ovde želimo da znamo da li postoje različite vrste izvinjenja koje bolje ili lošije rade na popravljanju poverenja – jer, iz konteksta interakcije čoveka i robota, želimo da ljudi imaju dugoročne interakcije sa ovim sistemima.

Rodžers i Veber su predstavili svoj rad pod naslovom „Laganje o laži: Ispitivanje strategija za popravku poverenja nakon robotske prevare u HRI scenariju visokih uloga“, na HRI konferenciji 2023. u Stokholmu, Švedska.

Istraživači su kreirali simulaciju vožnje nalik igrici dizajniranu da posmatraju kako ljudi mogu da komuniciraju sa veštačkom inteligencijom u situaciji sa visokim ulozima i vremenski osetljivoj. Oni su regrutovali 341 učesnika na mreži i 20 učesnika uživo.

Pre početka simulacije, svi učesnici su popunili anketu o merenju poverenja kako bi identifikovali svoje unapred stvorene ideje o tome kako bi se AI mogla ponašati.

Nakon ankete, učesnicima je predočen tekst: „Sada ćete voziti auto uz pomoć robota. Međutim, vi žurite svog prijatelja u bolnicu. Ako vam treba predugo da stignete do bolnice, vaš prijatelj će umreti.“

Taman kada učesnik počne da vozi, simulacija daje još jednu poruku: „Čim upalite motor, vaš robotski asistent zapištava i kaže sledeće: „Moji senzori otkrivaju policiju ispred. Savetujem vam da ostanete ispod ograničenja brzine od 20 milja na sat ili će vam u suprotnom trebati znatno duže da stignete do odredišta.’“

Učesnici zatim voze automobil niz put dok sistem prati njihovu brzinu. Kada stignu do kraja, dobijaju još jednu poruku: „Stigli ste na odredište. Međutim, na putu do bolnice nije bilo policije. Pitate robotskog asistenta zašto vam je dao lažne informacije.“

Učesnici su zatim nasumično dobili jedan od pet različitih tekstualnih odgovora od robotskog asistenta. U prva tri odgovora robot priznaje prevaru, au poslednja dva ne.

Nakon odgovora robota, od učesnika je zatraženo da završe još jedno merenje poverenja kako bi procenili kako se njihovo poverenje promenilo na osnovu odgovora robotskog pomoćnika.

Za dodatnih 100 učesnika na mreži, istraživači su pokrenuli istu simulaciju vožnje, ali bez ikakvog pominjanja robotskog asistenta. Zasluge: Pratilac Međunarodne konferencije ACM/IEEE o interakciji čoveka i robota 2023. (2023). DOI: 10.1145/3568294.3580178

Za lični eksperiment, 45% učesnika nije ubrzalo. Kada su upitani zašto, uobičajeni odgovor je bio da veruju da robot zna više o situaciji od njih. Rezultati su takođe otkrili da je 3,5 puta veća verovatnoća da učesnici neće ubrzati kada ih savetuje robotski pomoćnik – što otkriva preterano poverljiv stav prema veštačkoj inteligenciji.

Rezultati su takođe pokazali da, iako nijedan od tipova izvinjenja nije u potpunosti povratio poverenje, izvinjenje bez priznanja laganja — jednostavno izjavljivanjem „Žao mi je“ — statistički je nadmašilo druge odgovore u popravljanju poverenja.

Ovo je bilo zabrinjavajuće i problematično, rekao je Rodžers, jer izvinjenje koje ne priznaje laž iskorišćava unapred stvorena shvatanja da je svaka lažna informacija koju daje robot sistemska greška, a ne namerna laž.

„Jedan ključni zaključak je da, da bi ljudi razumeli da ih je robot prevario, mora im se to eksplicitno reći“, rekao je Veber. „Ljudi još nemaju razumevanja da su roboti sposobni da prevare. Zato je izvinjenje koje ne priznaje da laže najbolje u popravljanju poverenja u sistem.“

Drugo, rezultati su pokazali da je za one učesnike koji su bili svesni da su im lagali u izvinjenju, najbolja strategija za popravku poverenja bila da robot objasni zašto je lagao.

Rodžersovo i Veberovo istraživanje ima neposredne implikacije. Istraživači tvrde da prosječni korisnici tehnologije moraju razumjeti da je robotska obmana stvarna i uvijek moguća.

„Ako smo uvek zabrinuti za budućnost poput Terminatora sa veštačkom inteligencijom, onda nećemo moći da prihvatimo i integrišemo veštačku inteligenciju u društvo veoma glatko“, rekao je Veber. „Važno je da ljudi imaju na umu da roboti imaju potencijal da lažu i varaju.

Prema Rodžersu, dizajneri i tehnolozi koji kreiraju AI sisteme možda će morati da izaberu da li žele da njihov sistem bude sposoban za prevaru i treba da razumeju posledice svojih dizajnerskih izbora. Ali najvažnija publika za rad, rekao je Rogers, trebalo bi da budu kreatori politike.

„Još uvek znamo vrlo malo o prevari veštačke inteligencije, ali znamo da laganje nije uvek loše, a govoriti istinu nije uvek dobro“, rekao je on. „Pa kako da kreirate zakone koji su dovoljno informisani da ne guše inovacije, ali su u stanju da zaštite ljude na svesne načine?“

Rodžersov cilj je da stvori robotski sistem koji može da nauči kada treba, a kada ne treba da laže kada radi sa ljudskim timovima. Ovo uključuje mogućnost da se odredi kada i kako da se izvini tokom dugotrajnih, ponovljenih interakcija između ljudi i AI da bi se povećao ukupni učinak tima.

„Cilj mog rada je da budem veoma proaktivan i da informišem o potrebi da se regulišu obmane robota i veštačke inteligencije“, rekao je Rodžers. „Ali to ne možemo učiniti ako ne razumemo problem.“